No descubro nada si digo que Oracle Real Application Cluster (RAC) es un producto bien conocido entre las soluciones de Oracle para mantener una alta disponibilidad de los datos de cualquier negocio. Gracias a Oracle RAC puedes balancear la carga de trabajo, esta se comparte entre todos los nodos del clúster, con la configuración de tolerancia N-1 en caso de fallas de nodo, siendo N es el número total de nodos. Desde las primeras versiones Oracle RAC está mejorando constantemente en cada versión y esta vez no fue diferente.

La nueva versión 12.1.0.1 incorpora dos propiedades llamadas:

- Flex ASM

- Flex Cluster

,que dan soporte a los requisitos de demanda en entornos orientados a la computación en nube.

En la versión 12c Oracle RAC introduce dos nuevos conceptos:

- Nodos Hub: están conectados entre sí a través de una red privada y tienen acceso directo al almacenamiento compartido, al igual que las versiones anteriores. Estos nodos son los que acceden directamente al Oracle Cluster Registry (OCR) y Voiting Disk (VD).

- Nodos leaf: estos nodos son más ligeros y no están conectados entre ellos, ni acceden al almacenamiento compartido como los nodos de concentrador. Cada nodo hoja se comunica con el nodo concentrador que está conectado y está conectado al clúster a través del nodo concentrador vinculado.

Esta topología permite que los servidores de aplicaciones débilmente acoplados formen un clúster con servidores de bases de datos estrechamente acoplados. Los servidores estrechamente acoplados son servidores centrales que comparten el almacenamiento para dispositivos de base de datos, OCR y Voiting Disk (VD), así como la comunicación de igual a igual con otros servidores centrales en el clúster. Un servidor débilmente acoplado es un servidor Leaf que tiene una asociación de comunicación suelta con un solo Servidor Hub en el clúster y no requiere almacenamiento compartido ni comunicación de igual a igual con otros Servidores Hub o Leaf en el clúster, excepto para comunicarse con el Hub al que está asociado. En la versión de Oracle database 12.1.0.1, los servidores Leaf están diseñados para una mayor disponibilidad de aplicaciones y administración de recursos de múltiples niveles.

Lo bueno de Flex ASM es que el bloqueo de una instancia de ASM no arrastra las instancias de base de datos en el host. Imagine un entorno de base de datos como servicio en, por ejemplo, una máquina Exadata X3-8, esta máquina viene con 8s80c160t y 2 TB de memoria más 8 discos internos para binarios de Oracle. Esto debería ser una gran cantidad de equipos para consolidar sus bases de datos.

Ahora imagina lo que sucede si la instancia de ASM se bloquea ... o mejor no. Al introducir Oracle uzca Flex ASM puedes elegir el modo ASM durante la instalación de Grid Infrastructure 12c o habilitarlo más tarde.

Antes de la puesta en marcha de Oracle 12c, para que una instancia de base de datos use ASM, se esperaba que la instancia de ASM esté funcionando en todos los nodos antes de que se active la instancia de la base de datos. Si la instancia de ASM no aparece, significa que la instancia de la base de datos que utiliza ASM en el nivel de almacenamiento no se puede activar. Esto implicaliteralmente que no se puede acceder a la instancia de la base de datos sin importar las tecnologías puestas en uso, es decir:

- RAC

- ASM

- almacenamiento compartido

Al lanzar Oracle 12c, la restricción anterior se abordó con la función denominada Oracle Flex ASM, que principalmente tiene una función para conmutar por error a otro nodo del clúster.

Esencialmente una arquitectura de Hub y Leaf, la conexión de un nodo fallido se transfiere sin problemas a otro nodo participante mediante una instancia de ASM de reemplazo por Oracle Clusterware. El número de instancias de ASM que se ejecutan en un clúster dado se denomina cardinalidad de ASM con un valor predeterminado de 3. Sin embargo, el valor de cardinalidad se puede modificar con el comando Clusterware.

Mejores prácticas en Oracle Flex ASM

- Si tenemos un despliegue en modo mixto, recomendamos establecer la cardinalidad con el parámetro: ALL

- ¿Cuantas instancias ASM son necesarias?

- Para menos de cuatro nodos, una instancia ASM en cada nodo

- Para cuatro o mas nodos: Tres instancias ASM o todas si hay bases de datos pre 12c.

- ¿Cuantos Disk Groups son necesarios?

- 3 DATA, FRA y GRID

- GRID DG para OCR, Voting File, SPFILE

- Utiliza la redundancia externa para la mayoría de las matrices de almacenamiento de gama alta

- ¿Qué tamaño y cuántos discos hay en un grupo de discos?

- Discos mínimos: 4 veces el número de rutas para cada grupo de discos

- Grupo de discos de redundancia normal con rutas múltiples de 2 vías> = 8 discos

- Máximo: <1000 discos en un grupo de discos

- Tiempos de descubrimiento de disco largos y adiciones frecuentes de capacidad con demasiados discos

Oracle FLEX ASM

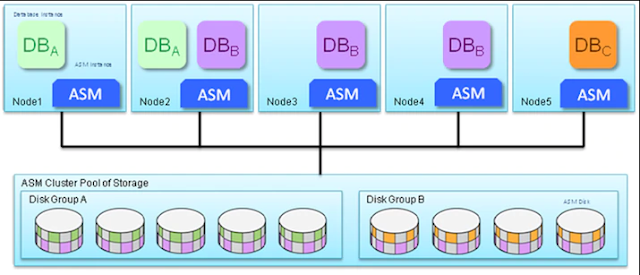

Arquitectónicamente, Oracle Flex Cluster se compone de una arquitectura de Hub y Leaf donde los nodos de Hub únicamente tendrán acceso directo tanto a Oracle Cluster Registry (OCR) y al Voting Disk (VD). Sin embargo, la aplicación puede acceder a la base de datos a través de los nodos Leaf sin que la instancia de ASM NO se ejecute en los nodos Leaf. La conexión a la base de datos se realiza a través de Hub, lo que la hace transparente para la aplicación.

¿Cómo implementamos Oracle FLEX ASM?

- Pure 12c Flex ASM (misma versión)

- Tanto la infraestructura de Grid (GI) como la base de datos se ejecutan en Oracle 12c

- Pre Oracle 12c Mixto (diferentes versiones)

Como instancia normal de ASM, se ejecutará en cada nodo con la configuración de Flex para admitir la base de datos pre 12c. El parámetro de compatibilidad del grupo de discos ASM se utiliza para administrar la compatibilidad entre y entre las instancias de base de datos. La ventaja de este enfoque es que si una instancia de la base de datos Oracle 12c pierde conectividad con una instancia de ASM, entonces las conexiones de la base de datos cambiarán a otra instancia de ASM en un servidor diferente. Este failover se logra estableciendo la cardinalidad a todos.

Se han implementado algunas mejoras:

Se han implementado algunas mejoras:

- Oracle Flex ASM admite tamaños de LUN más grandes para clientes de Oracle Database 12c.

- El número máximo de grupos de discos admitidos es 511, se ha aumentado desde 63.

- La reconexión de una instancia de base de datos hacia otra instancia de ASM es automática.

- La instancia de ASM usa Automatic Memory Management (AMM)

- Ningún parámetro especifico es requerido dentro de la base de datos para usar "Oracle Flex ASM".

- Ahora hay un comando para renombrar un "ASM Disk" en un "Disk Group".

Oracle RAC 12c con Oracle FLEX ASM

La configuración estándar de Oracle FLEX ASM sería:

Error de instancia de ASM en la configuración de Oracle Flex ASM:

1. Autentícate en la instancia RAC (rac1)

[oracle@oel6-112-rac1 Desktop]$ hostname

oel6-112-rac1.localdomain

2. Comprueba el estado de las instancias de la base de datos de ASM y RAC

[oracle@oel6-112-rac1 Desktop]$ ps -ef | grep pmon

oracle 3325 1 0 17:39 ? 00:00:00 asm_pmon_+ASM1

oracle 3813 1 0 17:40 ? 00:00:00 mdb_pmon_-MGMTDB

oracle 5806 1 0 17:42 ? 00:00:00 ora_pmon_orcl1

oracle 6193 1 0 17:42 ? 00:00:00 apx_pmon_+APX1

3. Comprueba el estado de la instancia de ASM en las instancias de la base de datos de RAC desde la instancia 1 (rac1)

[oracle@oel6-112-rac1 Desktop]$ srvctl status asm

ASM is running on oel6-112-rac2,oel6-112-rac1

4. Comprueba el estado de Cluster en instance1 (rac1)

[oracle@oel6-112-rac1 Desktop]$ crsctl check cluster

CRS-4537: Cluster Ready Services is online

CRS-4529: Cluster Synchronization Services is online

CRS-4533: Event Manager is online

5. Comando para verificar si Oracle Flex ASM está habilitado o no (rac1)

[oracle@oel6-112-rac1 Desktop]$ asmcmd

ASMCMD> showclustermode

ASM cluster : Flex mode enabled

ASMCMD> showclusterstate

Normal

6. Comando para cambiar la cardinalidad del ASM (rac1)

[oracle@oel6-112-rac1 Desktop]$ srvctl status asm -detail

ASM is running on oel6-112-rac2,oel6-112-rac1

ASM is enabled.

[oracle@oel6-112-rac1 Desktop]$ srvctl config asm -detail

ASM home: /u01/app/12.1.0/grid

Password file: +DATA/orapwASM

ASM listener: LISTENER

ASM is enabled.

ASM instance count: 3

Cluster ASM listener: ASMNET1LSNR_ASM

7. Comando para verificar si Oracle Flex ASM está habilitado o no (rac2)

[oracle@oel6-112-rac2 Desktop]$ asmcmd

ASMCMD> showclustermode

ASM cluster : Flex mode enabled

ASMCMD> showclusterstate

Normal

ASMCMD> exit

8. Cómo cambiar la cardinalidad del ASM (rac2)

[oracle@oel6-112-rac2 Desktop]$ srvctl config asm -detail

ASM home: /u01/app/12.1.0/grid

Password file: +DATA/orapwASM

ASM listener: LISTENER

ASM is enabled.

ASM instance count: 3

Cluster ASM listener: ASMNET1LSNR_ASM

9. Bajar la instancia de ASM en la instancia de la base de datos de RAC1 (rac1)

[oracle@oel6-112-rac1 Desktop]$ srvctl stop asm -node oel6-112-rac1 -stopoption abort -force

10. Comprueba el estado de la instancia de ASM en la instancia de la base de datos de RAC1 (rac1)

[oracle@oel6-112-rac1 Desktop]$ srvctl status asm

PRCR-1070 : Failed to check if resource ora.asm is registered

Cannot communicate with crsd

11. Comprobación del estado de los servicios de clúster en RAC Database instance1 (rac1)

[oracle@oel6-112-rac1 Desktop]$ crsctl check cluster

CRS-4535: Cannot communicate with Cluster Ready Services

CRS-4529: Cluster Synchronization Services is online

CRS-4533: Event Manager is online

12. Verificación del estado de la base de datos de ASM y RAC en la instancia 1 (rac1)

[oracle@oel6-112-rac1 Desktop]$ ps -ef | grep pmon

oracle 3813 1 0 17:40 ? 00:00:00 mdb_pmon_-MGMTDB

oracle 5806 1 0 17:42 ? 00:00:00 ora_pmon_orcl1

oracle 6193 1 0 17:42 ? 00:00:00 apx_pmon_+APX1

Aquí, una instancia de base de datos está asociada con la instancia ASM específica que se ejecuta en el nodo específico. Si, por alguna razón, si la instancia de ASM no se pudo activar / los servicios se desactiva, la instancia de la base de datos se puede activar ya que la instancia de la base de datos buscará una instancia de ASM que se ejecute en el mismo grupo. La Figura 3 muestra la alta característica disponible de Flex ASM.

13. Compruebe el estado de la instancia de la base de datos de RAC que se ejecuta sin la instancia de ASM en la instancia de base de datos de RAC1 (rac1)

[oracle@oel6-112-rac1 Desktop]$ . oraenv

ORACLE_SID = [orcl1] ? orcl1

ORACLE_HOME = [/home/oracle] ? /u01/app/oracle/product/12.1.0/db_1

The Oracle base remains unchanged with value /u01/app/oracle

14. nicie sesión en la instancia de la base de datos desde la instancia de la base de datos RAC1 (rac1)

[oracle@oel6-112-rac1 Desktop]$ sqlplus /nolog

SQL*Plus: Release 12.1.0.1.0 Production on Wed Sep 25 18:24:36 2013

Copyright (c) 1982, 2013, Oracle. All rights reserved.

SQL> connect sys/oracle@orcl as sysdba

Connected.

SQL> select instance_name,instance_number from gv$instance;

INSTANCE_NAME INSTANCE_NUMBER

-------------------------------------------

orcl2 2

orcl1 1

SQL> select instance_name,instance_number from v$instance;

INSTANCE_NAME INSTANCE_NUMBER

-------------------------------------------

orcl2 2

SQL> connect sys/oracle@orcl as sysdba

Connected.

SQL> select instance_name,instance_number from gv$instance;

INSTANCE_NAME INSTANCE_NUMBER

-------------------------------------------

orcl1 1

15. Conexión a la instancia ASM de la instancia de la base de datos de RAC2 (rac2) desde la instancia de la base de datos de RAC1 (rac1)

[oracle@oel6-112-rac1 Desktop]$ . oraenv

ORACLE_SID = [orcl1] ? +ASM2

ORACLE_HOME = [/home/oracle] ? /u01/app/12.1.0/grid

The Oracle base remains unchanged with value /u01/app/oracle

[oracle@oel6-112-rac1 Desktop]$ asmcmd --privilege sysasm --inst +ASM2

ASMCMD> lsdg

State Type Rebal Sector Block AU Total_MB Free_MB Req_mir_free_MB Usable_file_MB Offline_disks Voting_files Name

MOUNTED EXTERN N 512 4096 1048576 15342 4782 0 4782 0 Y DATA/

ASMCMD>

Oracle RAC 11.2 o anteriores con Oracle FLEX ASM

Como se mencionó en la introducción anterior para Oracle 12c, la asociación de ASM a la instancia de la base de datos es de naturaleza específica. Esto significa que si una instancia de ASM no se pudo activar, entonces la instancia de la base de datos asociada en ese nodo / ASM no se puede activar, lo que hace que la base de datos sea inaccesible.

1. Inicie sesión en la instancia de RAC Database1 (rac1)

login as: oracle

oracle@192.168.xx.xx's password:

Last login: Fri Sep 27 06:05:44 2013

2. Compruebe el estado de las instancias de la base de datos de ASM y RAC:

[oracle@rac1 ~]$ ps -ef | grep pmon

oracle 3053 1 0 05:56 ? 00:00:00 asm_pmon_+ASM1

oracle 3849 1 0 05:57 ? 00:00:00 ora_pmon_flavia1

3. Comprueba el estado de la instancia de ASM en la instancia de la base de datos de RAC1 (rac1)

[oracle@rac1 ~]$ srvctl status asm

ASM is running on rac2,rac1

4. Comprueba el estado de Cluster en RAC Database instance1 (rac1)

[oracle@rac1 ~]$ crsctl check cluster

CRS-4537: Cluster Ready Services is online

CRS-4529: Cluster Synchronization Services is online

CRS-4533: Event Manager is online

5. Detén la instancia de ASM en la instancia de la base de datos de RAC1 (rac1)

[oracle@rac1 ~]$ srvctl stop asm -n rac1 -o abort -f

6. Compruebe el estado de la instancia de ASM en la instancia de la base de datos de RAC1 (rac1)

[oracle@rac1 ~]$ srvctl status asm

ASM is running on rac2

7. Compruebe el estado de la instancia de la base de datos de ASM y RAC (rac1)

[oracle@rac1 ~]$ ps -ef | grep pmon

oracle 7885 5795 0 06:20 pts/0 00:00:00 grep pmon